本篇博客主要总结了 DeepLearning AI 公开课程 Prompt Engineering 提示词工程 第七章节 Expanding 扩充任务的内容,也可以理解为该章节的笔记。

扩充任务,顾名思义,就是给出一段文本,可以是主题或说明等,让 LLM 生成一段更长的文本,例如一篇文章、一份邮件。本章节还将引入一个模型参数,temperature 温度。这个参数允许我们调节模型的多样性程度。

0. 环境准备

之前的章节中,我们都没有单独列出调用 openai 的环境准备,因为它们都很简单,并且如果是要调用不同的大模型,API各有不同。因此,为了专注于 prompt ,之前的几个章节都将 setup 的环节略过了。但是在这个章节,我们将引入一个新的参数,temperature,来增加模型输出的多元化程度,因此在这里特地列出,和其他章节作一个区分。

1 | import openai |

1. AI 自动回复邮件

这个示例,演示了如何提供消费者的原始评论消息,指定语气和态度,自定义回复的电子邮件。

如下所示,提供了评论的情绪和评论原文。实际上,我们可以将任务拆分,在 prompt 中要求 LLM 先识别评论的情绪,再根据情绪进行回复。在这里,假定情绪识别任务已经完成,我们直接要求 LLM 根据情绪和评论撰写回复。

1 | # given the sentiment from the lesson on "inferring", |

1 | prompt = f""" |

在这段 prompt 中,我们先指明 LLM 当前扮演的角色,是一个销售部门的AI助理,任务是给有价值的客户回复邮件。邮件内容会用```标识,需要根据消费者的评论,生成一封感谢邮件,如果评论态度是负面的,则道歉并告知会改进消费者服务,如果是正向或者中立的,就表示感谢。另外,还要 LLM 使用评论中的具体细节,用简明、专业的语气撰写邮件。

2. 使用温度参数控制多元化程度

接下来,我们将介绍 temperature 参数的作用。这个参数能影响模型输出的多样性,即 temperature 的值能影响模型输出的随机性。但究竟什么是模型输出的多样性呢?直接解释定义或许有些抽象,我们通过一个示例来看。

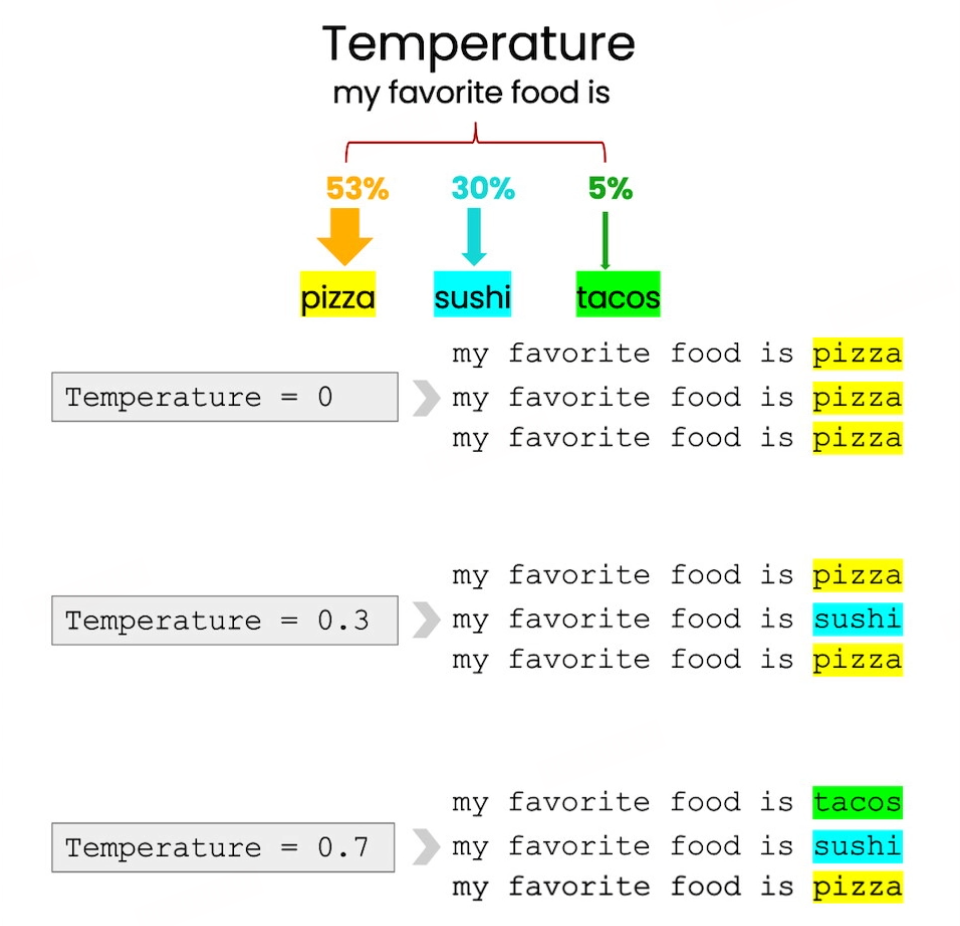

假如,我们输入一个短语,“我最喜欢的食物是……”,模型会预测最有可能的下一个单词是披萨(当然如果是中国大模型应该会是其他的答案),其次可能的是寿司和墨西哥卷。当 temperature = 0时,模型的多样性(随机性)最低,它将输出最有可能的、概率最高的答案,也就是披萨。但是当 temperature 被调高,它就可能会选择一个概率不那么高的单词,比如饺子。当温度更高时,甚至可能选择玉米卷。

下图就很生动地展示了 temperature 这个参数的作用情况。

当我们需要构建一个可预测的、可靠的系统时,维持默认的设定,temperature = 0即可。但如果希望模型更有创造性,更天马行空一点, 获得更多样的输出,就可以调高 temperature 参数。在之前的章节中,我们使用的都是默认设置,即 temperature = 0。你也可以尝试对它赋值,并重新运行一模一样的 prompt,看看输出发生了哪些变化。

Prompt Engineering 提示词工程笔记汇总

- 第一、二章:编写指示的几个指导原则

- 第三章:迭代 Iterative

- 第四章:摘要 Summarizing

- 第五章:推理 Inferring

- 第六章:转化 Transferring

- 第七章:扩充 Expanding

- 第八章:聊天机器人 ChatBot

参考资料

ChatGPT Prompt Engineering for Developers - DeepLearning.AI

B站可以找到搬运翻译的中文版本👆:《吴恩达 x OpenAI Prompt课程》

- 本文作者: Berry

- 本文链接: https://wuxinberry.github.io/2025/02/22/Prompt-tips6/

- 版权声明: 本博客所有文章除特别声明外,均采用 MIT 许可协议。转载请注明出处!