ComfyUI 相关博客目录:

这是一份 ComfyUI 的零基础入门指南。文本将介绍如何从零开始使用 ComfyUI,生成所需要的素材。本文注重实操,如果你对AI绘图的原理感兴趣,可以移步我的另一篇博客《AI绘图,是如何从算力到画面的》。了解一下 AI 生图的基本原理,也有助于我们选取模型、编写 prompt,调整参数。

或许一开始你觉得生成的图片差强人意,但是随着你逐渐进阶,只需要传几张风格图,输入一些指令,ComfyUI 分分钟就可以帮助你生成足以商用的广告图、海报、Logo 甚至是视频,为你节省大量的时间和资金成本。还在等什么,来,试试看!

ComfyUI 简介

如果你还不知道什么是ComfyUI,那么,最简单的介绍就是 ComfyUI 是一款 AIGC 工具,主要功能是输入图文、视频等,产出图片或视频。

市面上有许多生成式的AI工具。为什么要选择 ComfyUI 呢?相较于原生的 Stable Diffusion、Midjourney 等 AIGC 工具,SD Web UI 和 ComfyUI 将模型与工具分离。简单理解就是更容易实现自定义配置,有着更高的上限,更生成我们想要的风格的作品。

SD Web UI 和 ComfyUI 都对SD的工作流进行了拆分,WebUI 仍然是传统网页页面的形式,虽然能够自由输入、调整模型、安装插件,但是如果想要将输出作为下一个环节的输入,就需要切换页面,ComfyUI 则以节点为单位,更加自由,能够以类似于拼乐高的形式搭建AI生图的工作流程。

ComfyUI 安装

ComfyUI 的安装很简单,参考 ComfyUI 的GitHub主页,按照指定的方式进行安装即可。

虽然现在有很多的整合包、一键启动包,但是我仍然推荐使用 Git 进行本地安装,因为这样更新会更加方便。

在安装以前,有一点需要提醒的是,AI生图对算力的需求比较高,通常我们会用到配备有独立显卡的计算机。当然,ComfyUI 也支持使用 CPU 来计算,但是那样一来,出图的效率就会降低到 30%-40%。

安装

打包版本安装

- ComfyUI 官方提供了打包版本,进入上述官网,找到 “Direct link to download”,点击并下载。

- 下载完成后选择解压,可以得到 “ComfyUI_windows_portable” 文件夹。

- 进入到 “ComfyUI_windows_portable” 文件夹,根据自己的本机(或服务器配置),选择对应GPU或者CPU的运行方式,即双击运行run_nvidia_gpu.bat或run_cpu.bat。

- 注意,到这一步为止,只是成功运行了 ComfyUI,如果想要实际出图,还需要下载 Stable Diffusion 的模型。请将模型下载到 “ComfyUI_windows_portable\ComfyUI\models\checkpoints” 路径下。

推荐模型: v1-5-pruned-emaonly.ckpt, realisticVisionV60B1_v51VAE.safetensors,可以到文末推荐的C站下载。每次下载新的模型到路径,都要刷新或重启ComfyUI,才能够读取到,不然可能会检测不到对应的模型。

Git安装

- 安装并配置Git。这个网上教程很多,此处不加赘述。

- 安装并配置python环境。推荐使用Conda安装,并创建ComfyUI使用的虚拟 python 环境,可以参考网上教程。

- 在想要安装 ComfyUI 的文件路径下,右键打开 Git Bash(Terminal, CMD都行), 输入以下命令

1

git clone https://github.com/comfyanonymous/ComfyUI.git

- 等待Git将ComfyUI的项目拉取完成后,输入以下命令(如果使用的是虚拟环境,请提前激活。虚拟环境激活时,命令行前缀会出现虚拟环境的名字,如 (venv_py_comfyUI) C:User/…)

1

pip install -r requirements.txt

- 将SD模型放置在 models/checkpoints 下,将VAE模型放置在 models/vae,lora、controlNet 等模型也是一样。

- 完成后,切换路径在项目根目录下,输入以下命令启动ComfyUI

1

2

3python main.py

# 如果没有GPU 就使用

pythom main.py --cpu - 浏览器访问 127.0.0.1:8188,即可使用。

插件推荐

ComfyUI 有许多强大的插件拓展,极大地提升了它的功能,以下强推几个插件!非常好用!!

ComfyUI Manager 一个图形化管理工具,一站式集成了模型下载、插件安装、更新重启、设置等多种功能。可以说是使用ComfyUI必下的插件。

SDXL prompt styler 提供SDXL prompt styler节点,可以直接在这个节点选择生成的图片风格,不用再在prompt里面写描述。

upscale 用于放大、细化图片

IP-Adapter 实现单图lora效果,给一张风格图,能够提取输入的图片风格,输出一张类似风格的图片。

YoloWorld插件 输入图片或者视频,可以进行检测和分割,输出对应的蒙版

在搜索时可以带上 ComfyUI 关键词,更容易搜索到。

- ZHO-ZHO-ZHO 一个 ComfyUI 大佬的 GitHub 仓库,做了很多模型的 ComfyUI 迁移与插件化的工作,同时也会提供插件使用的 sample workflow 文件。

ComfyUI 的基础使用,以文生图demo为例

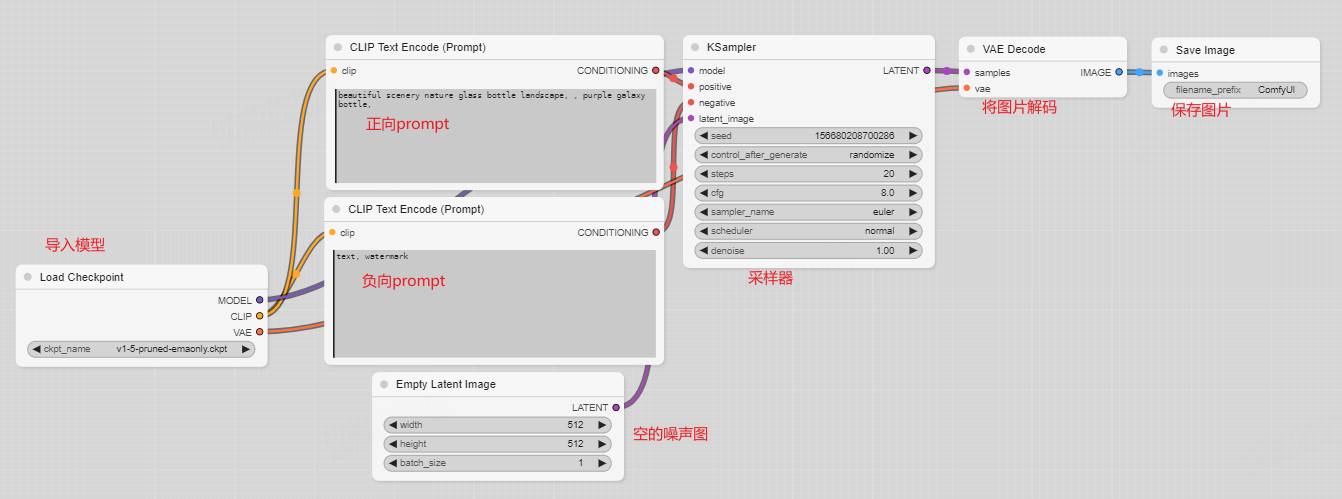

ComfyUI 的工作流是通过很多个工作节点连接起来的。将各个功能的节点,按照符合输入输出格式的方式连接起来,就可以搭建工作流。

认识基本节点

我们首先要认识一些基本的节点,了解其输入输出和起到的作用,才能够知道如何将它们连起来。现在,你或许还无法理解那些专业的名词到底是什么,但是没关系,大致有个概念即可。

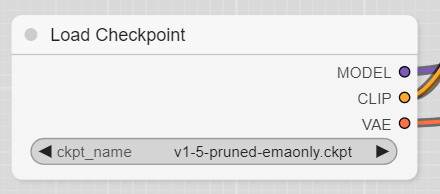

Load Checkpoint

载入 Diffusion、CLIP 和 VAE 模型,是工作流的起点。

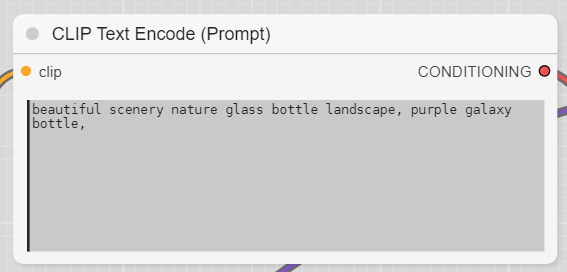

CLIP Text Encode(Prompt)

用于输入 prompt,使用逗号分割。

格式为 (keyword:weight),例 (hight building: 1.2) 可以控制 prompt 的权重。

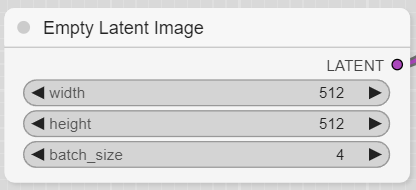

Empty Latent Image

空的潜空间图像节点(其实就是一张随机噪声图,不是里面的数据是空的意思),可以设置像素和每批生成的图片数量。

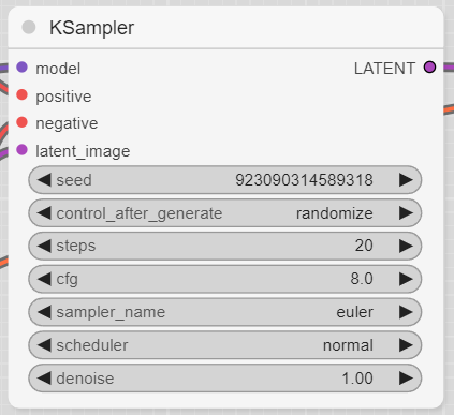

KSampler

采样算法控制器,其中的参数就是我们生成图片的过程中相当重要的采样算法、步数等参数。通常大家所说的“炼丹调参”,就是指调整这里的参数。以下是几个常用的参数介绍:

- seed 随机种子,控制初始噪声。

- steps 采样步数,通常控制在15-35,太大也未必有好的效果,反而会降低出图效率,太小则图片精度不够。

- sampler_name 采样算法。

- scheduler 去噪过程的调度算法。

不了解这些算法该怎么选择也没有关系,不同的模型偏好的参数都不一样,没有明确、唯一的最优解。在生图过程中多多尝试、调整,参考模型作者给出的最优参数,都能够提高出图质量。

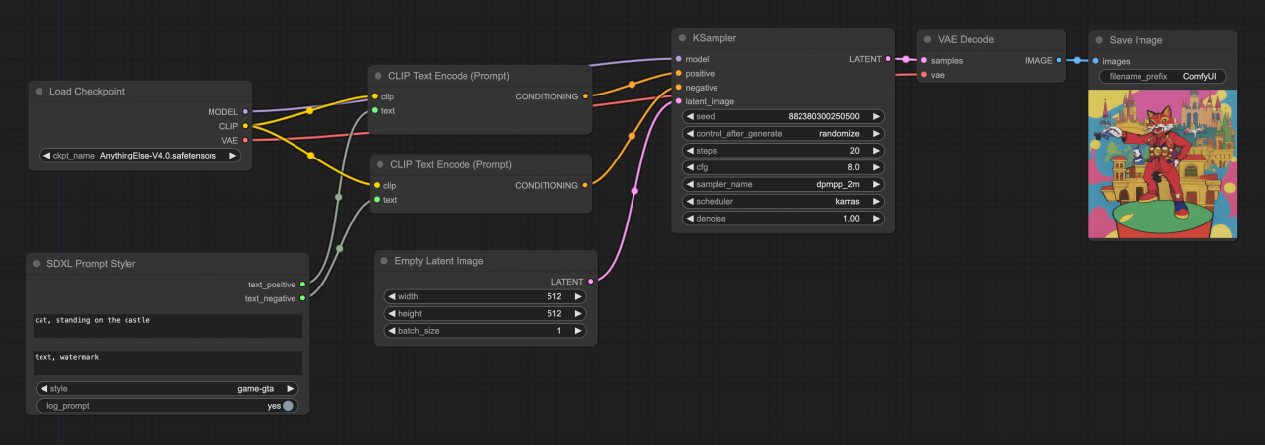

Demo: 搭建文生图工作流

认识了几个基础的节点以后,我们要学习如何将他们连接起来。

我们可以注意到,节点的左边或者右边,会有几个不同颜色的小圆圈,它们就是这个节点的输入、输入。左边是输入,右边是输出,不同的颜色对应了不同的数据类型。连线时,只有相同类型的数据,才能够被成功连上。

初次进入ComfyUI界面,初始化显示的就是一个文生图工作流:

如上图所示,每一个节点的功能都已经标注出来了。可以看到,相同颜色的节点通过线条连接,并且是从节点的右边输出,到节点的左边输入。

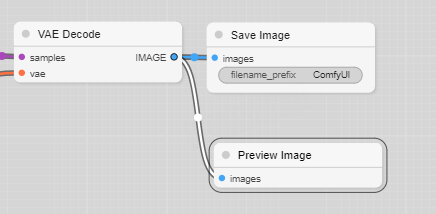

现在,我们再来增加一个预览图片的节点 PreviewImage。点击 VAE Decode 节点右边的蓝色小圆圈,往外拖动再松开,就可以看到一个菜单栏,找到 Preview Image 节点,点击即可创建。

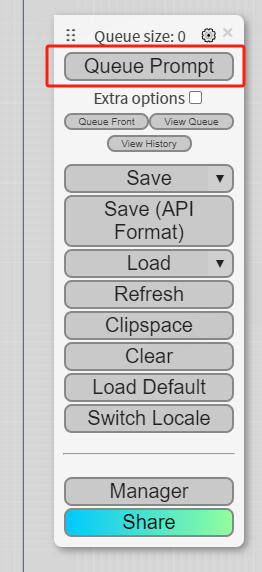

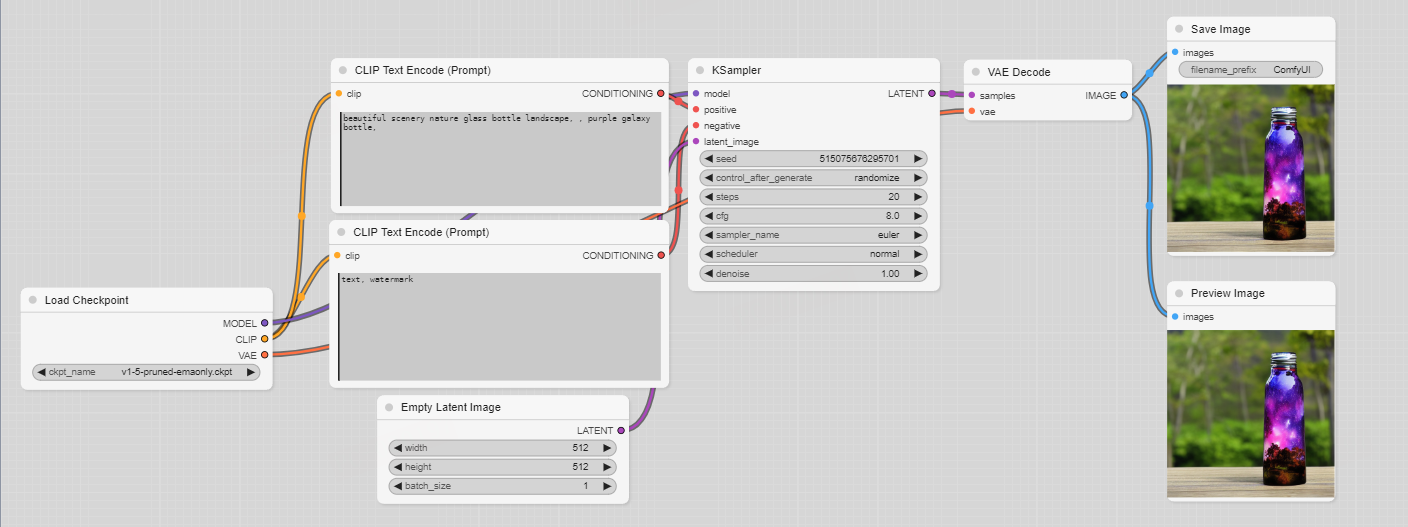

现在我们来运行一下这个工作流。点击右侧的 ”Queue Prompt“,这个按钮就等于开启一个绘图的工作队列。运行过程中,节点外面有绿色框框的,表示当前正在运行的节点。

顺便介绍一下这里的其他几个按钮,Save 表示保存当前的工作流为一个 json 文件,Load 则是导入一个 json 格式的工作流文件。Refresh 可以刷新当前载入的模型、下载的插件等。Clear 会清空当前页面的工作流。Load Default 会载入如我们上图所示的默认工作流。 Manager 则是我们之前推荐安装的 ComfyUI Manager 插件。

这样,我们就实现了一个文生图的基础流程。你还可以修改Emty Latent Image的参数,可以改变生成的图像大小和一批次生成的图片数量。

最佳实践

我们已经实现了从无到有的过程,那么该如何让生成的图片更符合我们的预期呢?这里有一些实践技巧。

Stable Diffusion 版本比较

一般情况下,Stable Diffusion v1.5 / Stable Diffusion v2.0 / Stable Diffusion XL 使用得比较广泛。但它们也有各自的优劣势。

- v1.5 是最早的版本,XL是最新的版本。

- 目前市场上很多 Lora 模型以及 ControlNet 模型都是基于v1.5来构建的,可用的模型比较多。

- v2.0 采用了新的文本编码器 OpenCLIP,可以更好地理解文本提示,支持更高的图像分辨率,可以生成默认分辨率为 512x512 像素和 768x768 像素的图像。

- XL 模型更大,生成图像质量更高,引入了新的功能,如更有艺术感的图像,更真实的图像,以及更清晰可读的字体等,但是对硬件要求也更高。

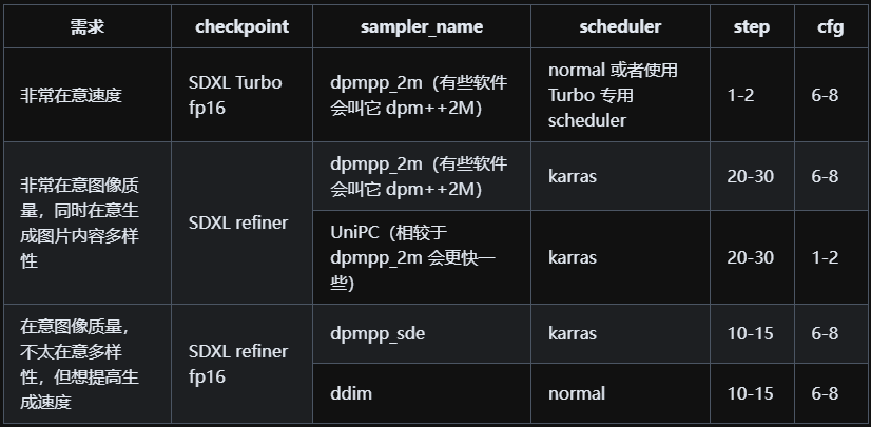

KSampler

KSampler的一些参数配置如下图所示。该图来自 Comflowy 的总结。

KSampler 的配置跟模型(checkpoint)强相关,比如 SDXL-Turbo 因为对图片生成过程进行了压缩,其最佳 cfg 反而不能太大,实验下来,1 或 4 最好。也可以参考下载的模型页面上作者提供的参数,通常都是该模型的最佳实践。

Prompt

如何写好你的 Prompt,这是在任何一个 AIGC 应用中都很重要的技能。不同的应用,偏好的 prompt 不同,学习 ComfyUI 的 prompt 范式,能够更好地传达你的意图,提升生成的图片的质量。

长度:不是越长越好,最好保持在75个 token(或约 60 字)以内,以精准描述为主。

排序:越重要的词越靠前。比如主体的描述要放在背景前。

符号

逗号:使用逗号分割 token

beautiful scenery, nature glass bottle landscape, purple galaxy bottle,

括号:使用括号调整权重,大于 1 表示权重变高,小于 1 表示权重降低。

(high building:1.2)

这里提供一个万金油的 prompt 模板:

- 主体(首位)

- 环境:主体所处的环境,环境的氛围、光线/灯光,天气

- 媒介:相机/油画/相片等

- 风格:什么年代的风格/哪位艺术家或者哪种艺术风格/什么国家或者文明的风格

如果你使用的是 SDXL 模型,那么可以安装 SDXL prompt styler插件。这个插件会提供一个SDXL prompt styler节点。使用这个节点,可以选择生成的图片风格,而不需要在 prompt 里面写风格描述。如下图所示,你可以轻松控制出图的艺术效果。

ComfyUI 学习资源参考

ComfyUI: ComfyUI的 GitHub 主页。

Comfylowy: 这是一个ComfyUI社区,介绍了ComfyUI的功能、安装使用以及一些基础的AI绘图的原理。

OpenArt: 当前最大的AIGC社区,有相当多的可用资源(各种风格模型、参考工作流等),但是需要魔法。

HuggingFace: 有很多免费的模型可以下载。

Civitai C站: C站上有非常多的模型资源可供下载,下载模型时记得留意作者的推荐参数。

另:B站和YouTube上也有很多ComfyUI的教程可供参考。

- 本文作者: Berry

- 本文链接: https://wuxinberry.github.io/2024/04/17/ComfyUI入门/

- 版权声明: 本博客所有文章除特别声明外,均采用 MIT 许可协议。转载请注明出处!